🔄 [Mis à jour en février 2026]

Synthèse des meilleurs modèles d'IA générative en 2026

Intégration avec les outils Google

Coût potentiellement élevé pour les entreprises

Performances élevées en analyse complexe

Sécurité renforcée

Accès restreint

Large adoption

Intégration avec de nombreux outils tiers

Dépendance à l’écosystème OpenAI

Performances élevées en codage

Accès limité

Performant en programmation

Performances élevées en multilingue

Mathématiques et codage

Intégré dans les produits Meta

Performant en multilingue et génération de code.

Absence de génération multimodale native

Intégration avec Creative Cloud

Accès limité aux utilisateurs d’Adobe

Efficacité malgré des ressources limitées

Performances élevées dans des tâches complexes

L’année 2026 marque un tournant majeur dans le domaine de l’intelligence artificielle générative. Après plusieurs années d’avancées rapides et parfois expérimentales, l’écosystème de l’IA entre désormais dans une phase de consolidation et de maturité technologique. Les modèles de nouvelle génération, qu’ils soient propriétaires ou open source, dépassent désormais le simple cadre du traitement de texte pour devenir des assistants polyvalents, capables de raisonner, de coder, de créer des images, de générer de la vidéo ou encore d’interagir vocalement.

Dans ce paysage en pleine effervescence, les géants comme OpenAI, Google DeepMind, Meta ou Anthropic rivalisent d’ingéniosité pour repousser les limites du raisonnement, de la contextualisation et de l’usage multimodal. En parallèle, de nouveaux acteurs européens comme Mistral AI ou des projets communautaires open source offrent des alternatives performantes, éthiques et accessibles.

Cet article propose une sélection rigoureuse des 10 meilleurs modèles d’IA générative en 2025, en tenant compte de leurs capacités techniques, de leurs cas d’usage, de leur accessibilité, ainsi que de leur impact potentiel sur les métiers, l’éducation, la recherche ou la création. Chaque modèle est analysé en détail à travers ses caractéristiques, ses avantages, ses limites, et son contexte de développement.

*Pour évaluer les modèles, nous utilisons trois indicateurs clés :

- MMLU : Teste les connaissances générales dans 57 domaines (médecine, droit, maths…), évaluant la polyvalence.

- MATH : Mesure le raisonnement logique via des problèmes mathématiques complexes, crucial pour les agents autonomes.

- MMMU : Évalue les capacités multimodales (images, graphiques), essentiel pour les usages professionnels.

Les scores proviennent des éditeurs eux-mêmes. L’absence de résultats peut indiquer une non-pertinence (ex. MMMU pour un modèle non multimodal) ou un manque de communication.

Gemini 2.5 Pro est le fleuron technologique de Google DeepMind, introduit en mars 2025. C’est un modèle multimodal natif de deuxième génération, conçu pour traiter de façon fluide des entrées textuelles, visuelles, auditives et vidéo — ce qui le rend idéal pour des applications complexes comme la recherche scientifique assistée par IA, la rédaction de contenus enrichis, l’analyse de vidéos ou de graphiques scientifiques, et la programmation.

Ce modèle s’appuie sur une architecture unifiée, à la différence des précédents modèles hybrides (comme GPT-4 + Vision ou PaLM-E), ce qui lui permet de passer sans transition d’un mode à l’autre (par exemple : interpréter un graphique, le décrire en langage naturel, puis générer du code Python pour le reproduire).

Je trouve que l’un de ses atouts majeurs est sa fenêtre contextuelle de 1 million de tokens, soit l’une des plus grandes jamais proposées à grande échelle. Cela permet à Gemini de digérer l’équivalent de milliers de pages de texte, plusieurs heures de transcription ou des jeux de données entiers.

Gemini 2.5 Pro est entièrement intégré à l’écosystème Google Cloud, Workspace, et même Android, avec des fonctionnalités exploitables via Vertex AI et des API spécifiques. Son API permet aussi un appel asynchrone pour des tâches intensives comme la génération de rapports juridiques, médicaux ou de synthèses d’études cliniques.

Cas d’usage privilégiés :

- Génération de contenus narratifs illustrés ou interactifs

- Recherche académique (analyse de données multimodales)

- Marketing avancé (campagnes générées automatiquement à partir d’analyses de marché)

- Éducation (assistants pédagogiques multimodaux)

Claude 3.7 Sonnet est l’aboutissement de la gamme Claude 3 d’Anthropic. Sorti en avril 2025, ce modèle symbolise l’approche d’IA “constitutionnelle” de la startup américaine. Il se positionne comme un modèle conversationnel avancé, axé sur la transparence, la sécurité et la qualité argumentative.

Ce modèle intègre une fonctionnalité de “thinking mode”, permettant à l’utilisateur de choisir entre une réponse immédiate (“instant mode”) ou une réponse réfléchie (“chain-of-thought”), offrant ainsi une interface adaptée aux cas d’usage professionnels comme les analyses juridiques, la stratégie d’entreprise ou les revues scientifiques. Claude 3.7 est également capable de raisonner à haute voix, détaillant ses étapes de réflexion — une avancée majeure pour la confiance et la vérifiabilité des réponses.

Avec une fenêtre contextuelle de 200 000 tokens, Claude 3.7 peut traiter des documents juridiques, techniques ou médicaux de grande envergure. Il offre aussi des capacités linguistiques avancées, avec une qualité presque native en anglais, français, espagnol et mandarin.

Il est proposé dans le cadre de l’API Claude (via Anthropic Cloud ou AWS Bedrock) et est déjà utilisé par des institutions financières, universités, cabinets de conseil et même gouvernements pour des tâches de veille stratégique, d’assistance à la décision et d’automatisation documentaire.

Particularités :

- Réponses pondérées et équilibrées

- Excellent dans la recherche documentaire

- Mode “réfléchi” avec structure logique visible

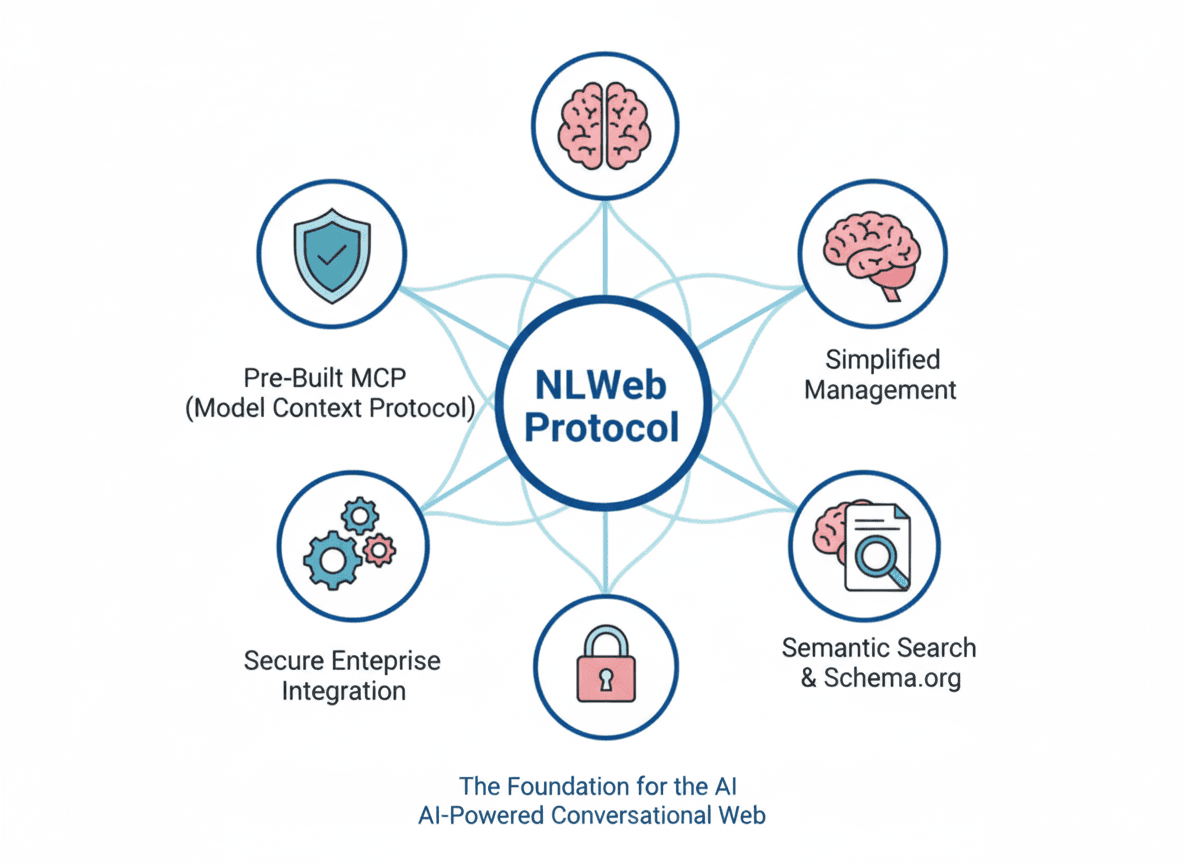

- Peut se connecter à d’autres systèmes grâce au MCP

ChatGPT-5 est encore officieusement nommé ainsi, mais de nombreux observateurs le considèrent comme l’évolution directe de GPT-4 Turbo. Il est disponible depuis début 2025 dans la version Pro de ChatGPT. Ce modèle incarne l’ambition d’OpenAI de créer une IA utile, personnalisable, multimodale et intégrée dans les workflows réels.

GPT-5 améliore substantiellement le raisonnement logique, les capacités de planification et la gestion du contexte à long terme. Avec une fenêtre contextuelle de 256 000 tokens, il peut traiter des bases de connaissances entières, générer des plans d’action complexes ou résumer des corpus volumineux. Il prend en charge le texte, les images (via GPT-4 Vision), le son (Whisper intégré) et même des fonctionnalités vidéo expérimentales via des plugins partenaires.

OpenAI a aussi intégré des fonctions de “memory”, permettant au modèle de se souvenir de faits pertinents sur les préférences, projets ou habitudes d’un utilisateur, dans un cadre respectueux de la vie privée.

ChatGPT-5 peut être utilisé comme un agent autonome via les GPTs personnalisés : on peut le transformer en assistant fiscal, coach d’écriture, programmeur de scripts ou analyste de données, le tout sans coder. Il est intégré dans Microsoft 365 (Copilot), Slack, Notion, Discord et d’autres plateformes. C’est personnellement celui que j’utilise le plus au quotidien.

Grok 3, lancé par xAI début 2025, est un modèle d’IA open core intégré à X (anciennement Twitter). À la croisée de la recherche scientifique, de la satire internet et de la performance algorithmique, Grok 3 incarne l’approche non conventionnelle de la société fondée par Elon Musk.

Ce modèle se distingue par sa capacité à dialoguer sur des sujets techniques (physique, mathématiques, ingénierie, codage) avec un ton souvent sarcastique ou provocateur, mais des performances solides. Grok 3 a été entraîné sur les données en temps réel provenant de la plateforme X, lui donnant un avantage sur l’actualité, les tendances sociales et l’opinion publique. Il est l’un des seuls modèles à utiliser des mises à jour quasi-instantanées du web social comme source de connaissance.

Grok 3 offre aussi une architecture de calcul parallèle permettant le raisonnement décentralisé, où les sous-composants du modèle peuvent réfléchir à différentes hypothèses avant de fusionner une réponse. Cela favorise une meilleure précision dans les réponses analytiques ou scientifiques.

Il est intégré gratuitement dans X Premium+, mais aussi disponible via une API privée pour les développeurs. Un module image nommé Aurora, encore en phase expérimentale, permet aussi une génération visuelle réaliste (portraits, paysages, mèmes).

Mistral Large 2, dévoilé en mars 2025, est le nouveau modèle phare de la startup française Mistral AI, positionnée comme l’alternative européenne à OpenAI et Anthropic. Ce modèle est une évolution du Mistral Large initial sorti en 2024, mais avec une amélioration significative des performances, notamment sur le raisonnement, la génération de code, et la compréhension de textes techniques.

Conçu dans une logique de souveraineté technologique, Mistral Large 2 se distingue par sa qualité de réponse équivalente à GPT-4 Turbo, tout en étant optimisé pour une infrastructure européenne et open source. Ce modèle prend en charge une fenêtre contextuelle étendue de 65 000 tokens, ce qui le rend très efficace pour l’analyse de longs documents (comme des rapports législatifs, de la documentation technique ou des jeux de données bruts).

Là où Mistral innove particulièrement, c’est dans sa stratégie de distribution. Mistral Large 2 est disponible via une API hébergée en Europe, via le cloud Scaleway ou OVHcloud, mais aussi intégrable dans des serveurs privés ou des clouds souverains. Je pense qu’il est parfaitement adapté aux cas d’usage gouvernementaux, de recherche ou d’entreprise nécessitant un haut niveau de sécurité des données.

Il prend en charge le multilingue de manière très robuste (notamment français, allemand, espagnol, arabe), avec une capacité rédactionnelle fluide et fiable. Bien que non open source, son API est libre d’usage sans verrou propriétaire.

Mixtral 8x22B est une innovation majeure de Mistral AI, basée sur l’architecture dite “Mixture of Experts” (MoE). Lancé fin 2024, ce modèle repose sur un ensemble de 8 experts, chacun doté de 22 milliards de paramètres. À chaque requête, seulement 2 experts sont activés, ce qui permet d’atteindre des performances comparables à celles d’un modèle de plus de 100 milliards de paramètres, tout en limitant le coût de calcul.

Ce modèle est open source, disponible sous licence Apache 2.0, ce qui le rend particulièrement attractif pour les chercheurs, développeurs et entreprises soucieuses de la transparence et de la personnalisation. Il est optimisé pour le raisonnement logique, les calculs mathématiques, la génération de code, et l’analyse textuelle complexe.

Mixtral 8x22B surpasse LLaMA 2 70B et MPT-30B dans les benchmarks d’efficacité, de cohérence linguistique et de précision sur les tâches en anglais comme en français. Il fonctionne parfaitement sur des infrastructures open source (via Hugging Face, Ollama ou LM Studio) et peut être déployé sur des machines locales ou des clusters.

Son architecture modulaire permet également un finetuning ciblé, où chaque expert peut être entraîné différemment pour des tâches spécialisées (médical, juridique, technique). Cela ouvre la voie à des applications sur mesure dans les secteurs régulés.

LLaMA 3, publié en avril 2025 par Meta AI, est la dernière génération de la série LLaMA (Large Language Model Meta AI), connue pour son impact considérable dans la communauté open source. Cette version marque un bond qualitatif important, avec une architecture optimisée, des capacités de raisonnement accrues, et une prise en charge étendue du multilingue.

Le modèle est disponible en deux variantes principales : LLaMA 3 8B (léger) et LLaMA 3 70B (équivalent à GPT-3.5 en performances), tous deux publiés sous licence permissive. Meta annonce aussi une version multimodale et orientée agents IA, prévue plus tard en 2025, ce qui ferait de LLaMA 3 la première série de modèles vraiment évolutive et personnalisable à large échelle.

LLaMA 3 a été entraîné sur plus de 15 000 milliards de tokens, incluant des corpus diversifiés en plusieurs langues. Il surpasse les modèles précédents dans les tâches de génération de code, de résumé long, de QA multilingue, et de génération d’idées. Il est aussi très utilisé dans les assistants open source (via LM Studio, Ollama, OpenDevin, etc.).

L’un des atouts majeurs de LLaMA 3 est sa compatibilité avec la plupart des bibliothèques open source, comme Hugging Face Transformers, LangChain, ou encore la plateforme LeChat. Meta mise sur une large adoption communautaire plutôt qu’une centralisation, ce qui fait de LLaMA 3 un pilier de l’IA libre.

Adobe Firefly 4 Ultra est la dernière itération du modèle d’IA générative d’Adobe, spécifiquement conçu pour la création visuelle de haute qualité. Lancé début 2025 et intégré nativement à la suite Creative Cloud (Photoshop, Illustrator, Premiere Pro, etc.), Firefly 4 Ultra repousse les limites de la génération d’images, de vidéos et d’effets visuels. Il est capable de générer des visuels en résolution 2K à partir d’instructions textuelles (texte-to-image), mais aussi d’améliorer ou transformer des images existantes à partir de simples modifications décrites en langage naturel.

Je n’ai pas encore eu l’opportunité de le tester, mais ce modèle se distingue par sa capacité à respecter des styles artistiques précis, à produire des rendus cohérents sur plusieurs scènes, et à intégrer des éléments typographiques de manière créative (texte stylisé, lettrage 3D, etc.). Firefly est également optimisé pour la génération de contenu commercialement sûr grâce à son entraînement sur des données entièrement sous licence Adobe Stock et Creative Commons. Cela réduit les risques liés aux droits d’auteur, un point crucial pour les entreprises, agences et créateurs de contenu professionnels.

Parmi ses nouvelles fonctionnalités, Firefly 4 Ultra inclut :

- Le style transfer avancé (adaptation fidèle d’un style d’image à une autre)

- La génération de séquences animées à partir d’images statiques

- L’intégration directe avec l’éditeur vidéo Adobe Premiere pour créer des arrière-plans générés ou modifier des scènes

DeepSeek Janus-Pro est un modèle d’IA générative spécialisé dans la création d’images, développé par la startup chinoise DeepSeek AI. Malgré sa relative jeunesse, l’entreprise a réussi à imposer Janus-Pro comme un concurrent sérieux de DALL·E 3 et de Stable Diffusion 3 grâce à une combinaison de puissance, accessibilité et créativité. Le nom “Janus” fait référence au dieu romain aux deux visages, symbolisant la capacité du modèle à comprendre et à générer à la fois des représentations réalistes et stylisées.

Janus-Pro a été entraîné sur un corpus massif d’images annotées, incluant aussi bien des œuvres d’art numériques que des photographies haute définition. Il propose plusieurs modes de génération : photoréalisme, style peinture numérique, anime/manga, architecture, etc. Ce modèle excelle également dans la génération de scènes complexes avec des interactions cohérentes entre personnages et objets, ce qui est encore difficile pour la plupart des modèles du même genre.

Sa grande force réside dans sa flexibilité : les utilisateurs peuvent ajuster des paramètres fins tels que le niveau de détail, la profondeur de champ, l’orientation de la lumière ou la dynamique des couleurs. Bien qu’actuellement principalement utilisé sur le marché chinois, j’ai vu qu’il commence à se diffuser dans des outils d’édition graphique à l’international.

Moonshot Kimi k1.5 est un modèle conversationnel (chatbot) développé par la société chinoise Moonshot AI, lancé début 2025. Il a été pensé dès le départ pour répondre à des besoins spécifiques en Chine : traitement de très longs documents, conversation soutenue en mandarin, assistance académique et génération de code. La spécificité la plus marquante de Kimi réside dans sa capacité à gérer des fenêtres contextuelles gigantesques (plus de 2 millions de tokens), ce qui lui permet de comprendre et d’exploiter des corpus entiers de texte sans perte de cohérence.

Contrairement à de nombreux modèles occidentaux qui misent sur la rapidité de réponse, Kimi k1.5 favorise la profondeur : il peut analyser un PDF complet de plus de 1000 pages, générer des résumés intelligents ou répondre à des questions complexes avec des références croisées. Dans l’enseignement supérieur et la recherche, cela en fait un outil précieux, à la fois pour la préparation de publications, la lecture de corpus scientifiques ou encore l’analyse juridique.

Son interface est simple mais puissante, avec une gestion efficace de l’historique de session, une segmentation automatique des réponses, et la possibilité de gérer des tâches très spécifiques (génération de tableaux, formatage académique, etc.).

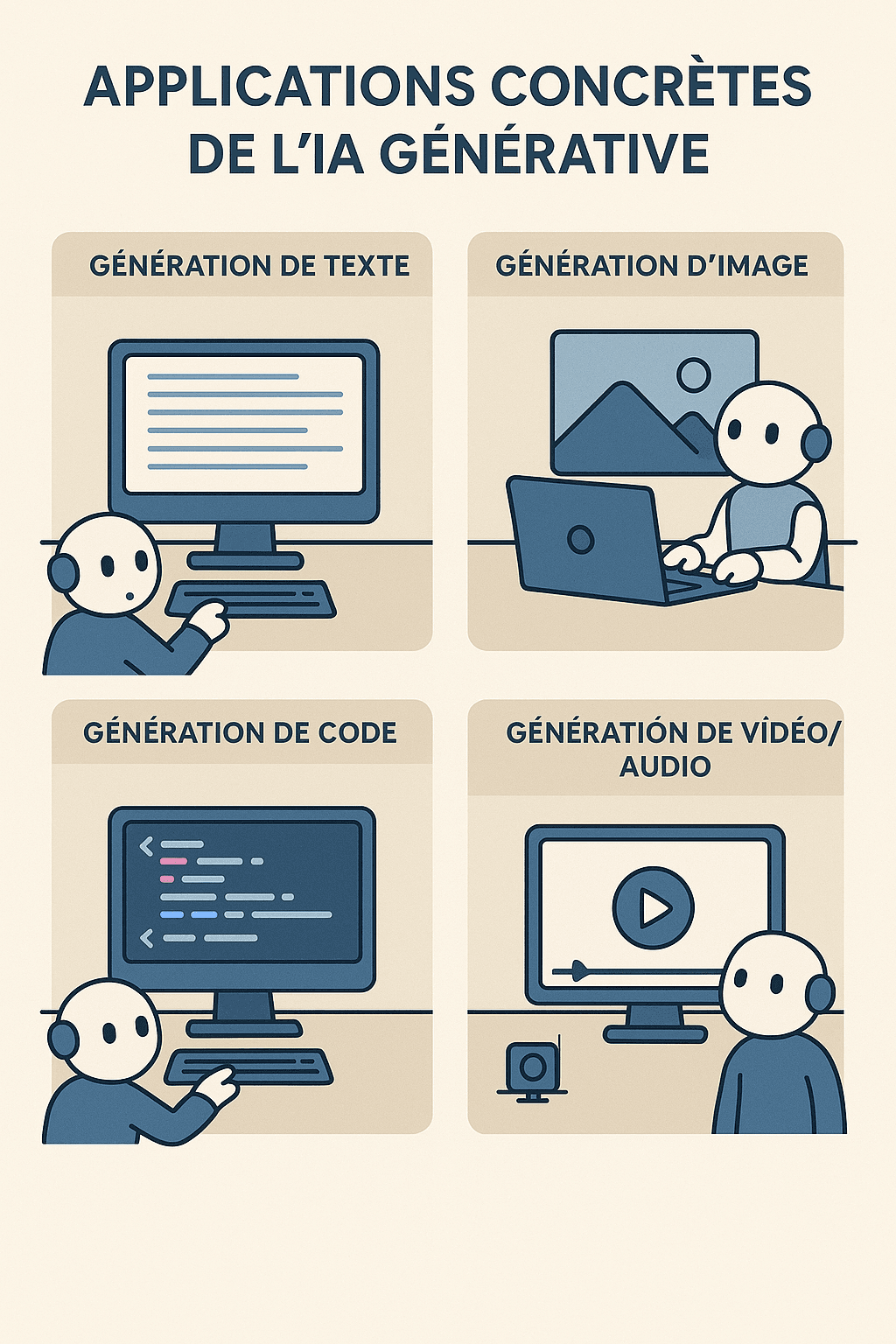

Un modèle d’intelligence artificielle générative est un système informatique entraîné à produire du contenu original — texte, image, audio, vidéo ou code — à partir d’une simple consigne ou d’un prompt rédigé en langage naturel. Contrairement aux IA traditionnelles, conçues pour classer, détecter ou prédire sur la base de données structurées, les modèles génératifs utilisent des architectures neuronales avancées, comme les transformers, pour apprendre les structures, les styles et les régularités statistiques d’énormes volumes de données non structurées (livres, images, sites web, conversations, etc.). Une fois entraîné, un modèle génératif peut imiter ces structures pour produire des résultats qui semblent humains, voire créatifs. Le plus connu de ces modèles est sans doute GPT (Generative Pretrained Transformer), développé par OpenAI, capable de rédiger des textes argumentés, répondre à des questions ou simuler des dialogues.

Mais il en existe de nombreuses variantes selon le type de données générées : DALL·E ou Midjourney pour les images, MusicGen pour l’audio, Sora pour la vidéo, ou encore Code LLaMA pour la génération de code informatique. Ces modèles fonctionnent sur le principe de complétion probabiliste : à chaque étape, l’IA prédit l’élément suivant (mot, pixel, note, image, etc.) le plus probable, en tenant compte du contexte fourni.

Les applications de ces IA génératives sont vastes : assistants virtuels, automatisation de la création marketing, conception de jeux vidéo, aide à l’écriture, design produit, ou encore prototypage rapide. Cependant, cette puissance soulève aussi des questions éthiques importantes : production de désinformation, biais culturels, plagiat ou encore perte de contrôle sur les contenus générés. Comprendre ce qu’est un modèle d’IA générative, c’est donc appréhender une technologie qui, au-delà de l’innovation technique, redéfinit la frontière entre création humaine et automatisation algorithmique, avec des implications profondes pour la société, l’économie, et la culture.

Il y a encore un an, l’intelligence artificielle générative était perçue comme une technologie prometteuse, mais encore limitée à des usages expérimentaux ou de niche. En l’espace de quelques mois seulement, la montée en puissance des modèles comme ChatGPT-5, Gemini 2.5, Claude 3.7 ou Mixtral 8x22B a changé la donne. Le rythme des avancées est si rapide qu’il dépasse parfois la capacité d’adaptation des professionnels. L’IA ne se contente plus d’optimiser les processus marketing : elle les réinvente radicalement.

Les outils de génération de texte, d’images, de vidéos et de voix atteignent désormais un niveau de qualité tel qu’ils permettent de produire en quelques minutes ce qui nécessitait auparavant des jours de travail. Des campagnes entières peuvent être conçues, testées et personnalisées à grande échelle sans intervention humaine directe. Le marketing de masse cède progressivement la place à un marketing ultra-ciblé, contextuel et génératif, capable de produire un contenu unique pour chaque client, en temps réel.

Mais cette puissance soulève autant d’opportunités que de questions. Les marques doivent redéfinir leur rôle : dans un monde où n’importe qui peut générer des vidéos publicitaires en quelques clics, la valeur ne réside plus dans la production, mais dans l’idée créative, la stratégie narrative et l’éthique de communication. Le positionnement devient une affaire de cohérence et de discernement, non de volume.

Par ailleurs, l’IA générative pourrait contribuer à une infobésité algorithmique : la multiplication de contenus générés sans filtre ou sans ligne éditoriale claire risque de noyer les consommateurs dans une mer de messages automatisés, souvent sans âme. Le marketing devra réapprendre à se différencier non par l’abondance, mais par l’authenticité.

Enfin, les compétences métiers évoluent rapidement. Les marketeurs de demain ne seront pas ceux qui écrivent des slogans, mais ceux qui orchestrent des IA créatives, interprètent les données générées, et veillent à leur pertinence culturelle et sociale. Le défi n’est plus technique, mais humain.

En résumé, je pense que l’IA générative représente une révolution aussi profonde que celle d’Internet en son temps. Mais comme toute révolution, elle impose une exigence : celle de penser avant d’automatiser, et d’écouter avant de générer.

L’analyse des 10 modèles d’IA générative les plus performants en 2026 révèle un paysage aussi diversifié que prometteur. Si les géants du secteur comme OpenAI avec ChatGPT-5, Google avec Gemini 2.5 Pro ou Anthropic avec Claude 3.7 Sonnet continuent de dominer par leur puissance de calcul et leur intégration dans des écosystèmes globaux, je trouve que les alternatives open source comme LLaMA 3 ou Mixtral 8x22B prouvent qu’innovation et accessibilité peuvent aller de pair.

Les tendances majeures de cette année sont claires : la multimodalité, la personnalisation, la résolution de tâches complexes, et une meilleure gouvernance éthique des modèles. Le choix entre solutions centralisées ou décentralisées dépendra de l’usage visé : automatisation de la production, support à la décision, création artistique, ou encore traitement de données critiques.

Loin d’être une simple évolution technologique, l’IA générative de 2025 redéfinit profondément les modes d’interaction entre humains et machines. De mon point de vue, elle s’impose désormais comme une infrastructure cognitive de nouvelle génération, appelée à s’intégrer dans tous les secteurs. Choisir le bon modèle revient alors à identifier non seulement sa puissance, mais aussi son adéquation à vos besoins, votre éthique et votre environnement.

Quelle est la différence entre une IA générative et une IA classique ?

Une IA générative crée du contenu (texte, image, son, etc.), tandis qu’une IA classique se limite à analyser, classer ou prédire à partir de données existantes.

Les IA génératives peuvent-elles remplacer les créateurs humains ?

Elles peuvent automatiser certaines tâches créatives, mais ne remplacent pas l’intuition, l’émotion ou le sens stratégique qu’apporte un humain.

Est-ce que toutes les IA génératives sont open source ?

Non, certaines sont open source (comme LLaMA 3 ou Mistral), mais les plus puissantes (comme GPT-5 ou Gemini) restent propriétaires.

Est-ce que les IA génératives sont fiables à 100 % ?

Non, elles peuvent produire des erreurs, des hallucinations ou des biais, et doivent donc être utilisées avec esprit critique.

Quels sont les domaines où l’IA générative est la plus utilisée aujourd’hui ?

Principalement dans le marketing, le service client, la création de contenu, la programmation et l’éducation.

Est-il légal d’utiliser une IA générative pour créer du contenu commercial ?

Oui, mais il faut respecter les droits d’auteur, les réglementations sur les données et la transparence envers les utilisateurs.

Quelle est la différence entre ChatGPT et OpenAI ?

ChatGPT est un produit de génération de texte basé sur l’intelligence artificielle, tandis qu’OpenAI est l’entreprise qui le développe et l’édite.