Lorsque vous interrogez Google en mode IA, vous ne voyez plus ces fameux liens bleus qui ont défini la recherche pendant des décennies. À la place, une réponse fluide et contextuelle apparaît, souvent accompagnée d’éléments multimédias et parfois même anticipant vos prochaines questions. Cette transformation radicale n’est pas qu’une simple amélioration d’interface, elle représente un changement fondamental dans la manière dont l’information est traitée, analysée et restituée.

Derrière cette apparente simplicité se cache une mécanique d’une complexité inédite, où des modèles de langage avancés, des systèmes de raisonnement artificiel et des techniques de personnalisation poussées travaillent de concert. Pour les professionnels du SEO/GEO, cette évolution n’est pas sans rappeler les bouleversements provoqués par des mises à jour algorithmiques majeures comme Panda ou Penguin, mais avec une ampleur bien plus considérable.

L’architecture cachée du mode IA : une machine à raisonner

Au cœur du mode IA se trouve un processus sophistiqué que Google appelle le “Query Fan-Out”. Contrairement à la recherche traditionnelle qui traitait chaque requête de manière isolée, le système génère maintenant des dizaines, voire des centaines de sous-requêtes dérivées. Prenons l’exemple d’une recherche apparemment simple comme “meilleur SUV électrique”. En réalité, Google va explorer toute une constellation de requêtes connexes : des comparaisons spécifiques entre modèles, des considérations techniques comme l’autonomie ou la recharge, des aspects pratiques adaptés au profil de l’utilisateur, et bien d’autres angles que l’utilisateur n’a même pas envisagés.

Cette explosion des requêtes cachées alimente ce que les brevets Google nomment le “Custom Corpus”, une sélection ultra-ciblée de documents pertinents pour la requête spécifique, à un moment donné, pour un utilisateur particulier. La magie opère grâce à la conversion de chaque élément, requêtes, documents, passages, et même utilisateurs, en représentations mathématiques appelées embeddings vectoriels. Ces vecteurs permettent au système de calculer des similarités sémantiques bien au-delà de ce que permettaient les anciennes méthodes basées sur les mots-clés.

Mais je pense que la véritable innovation réside dans les “Reasoning Chains” ou chaînes de raisonnement. Plutôt que de simplement compiler des informations, l’IA de Google construit désormais des réponses à travers une série d’étapes logiques interconnectées. Elle interprète d’abord l’intention sous-jacente (“L’utilisateur cherche-t-il un véhicule familial ?”), formule des hypothèses (“Prioriser l’espace intérieur et la sécurité”), puis valide ces conclusions en croisant plusieurs sources. Ce processus rappelle la manière dont un expert humain aborderait un problème complexe, mais à une échelle et une vitesse inaccessibles à notre cerveau.

Repenser la création de contenu pour l’ère de l’IA générative

Dans ce nouveau paradigme avec l’IA générative, les anciennes pratiques de SEO montrent rapidement leurs limites. L’optimisation pour des mots-clés spécifiques ou même pour des pages entières ne suffit plus. Le contenu doit maintenant être conçu pour répondre à plusieurs exigences simultanées.

Premièrement, chaque passage significatif doit pouvoir fonctionner de manière autonome. Les modèles de langage modernes extraient et recombinent des fragments d’information, rarement des pages complètes. Une phrase bien structurée comme “La Tesla Model Y offre 330 km d’autonomie selon le cycle EPA, avec un temps de recharge de 15 minutes pour 270 km” a bien plus de valeur qu’un paragraphe vague bourré de mots-clés.

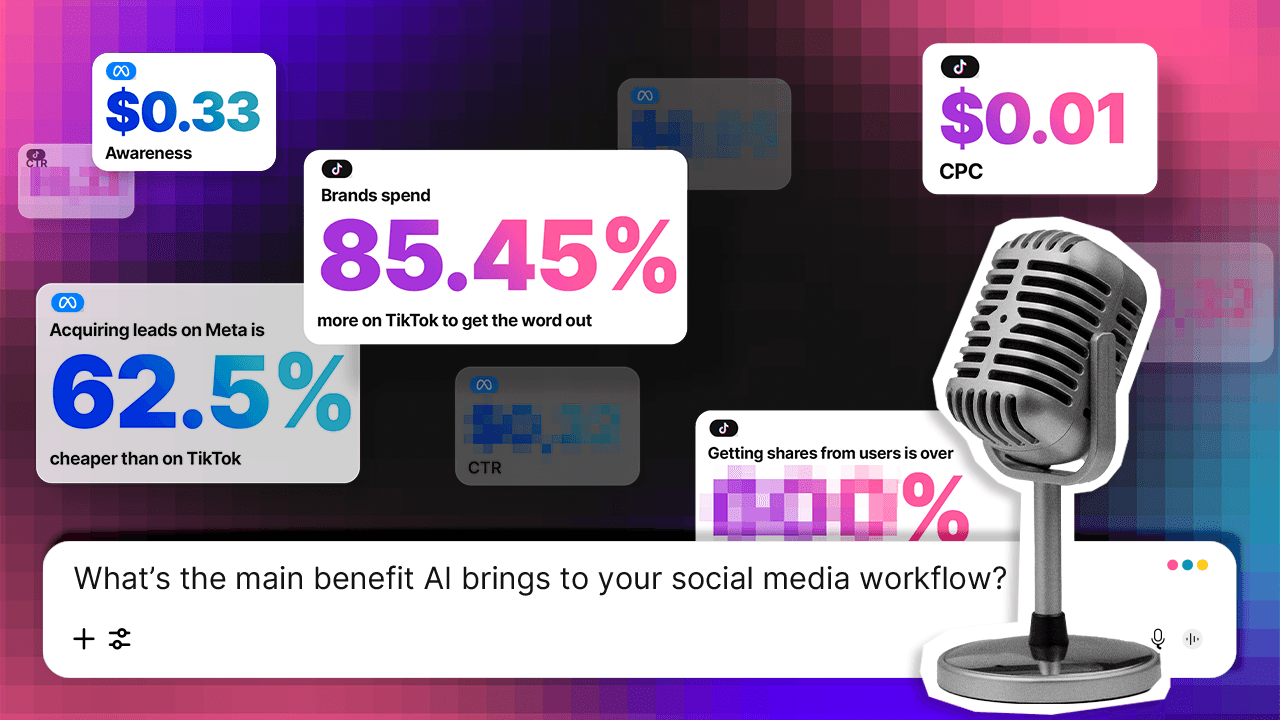

Deuxièmement, les comparaisons explicites deviennent cruciales. Les données montrent que près de 60% des interactions en mode IA impliquent une forme de prise de décision. Un contenu qui présente clairement les avantages et inconvénients (“Le Mustang Mach-E propose une conduite plus sportive mais avec 20% d’autonomie en moins que la Model Y”) a bien plus de chances d’être utilisé dans les réponses générées.

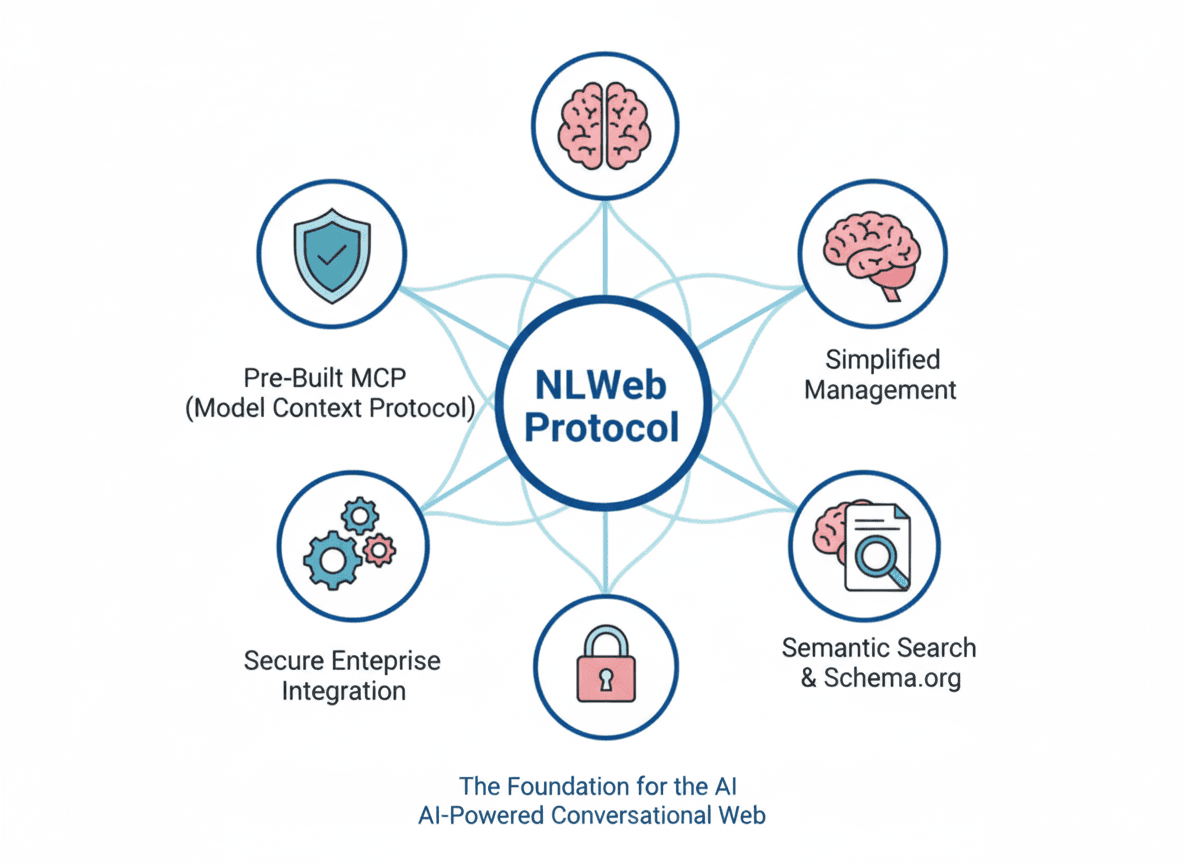

Je trouve que la structure joue également un rôle déterminant. Les listes à puces, les tableaux comparatifs, les FAQ et autres formats modulaires ne sont plus simplement des éléments de confort utilisateur, ils deviennent des atouts techniques qui facilitent l’extraction et la réutilisation de l’information par les systèmes IA. De même, l’usage rigoureux de données structurées via Schema.org fournit à Google des repères clairs pour interpréter et citer correctement le contenu.

Enfin, l’importance des sources vérifiables ne peut être sous-estimée. Dans un environnement où l’IA synthétise des réponses, les informations accompagnées de références précises (“Selon un rapport de l’EPA publié en mars 2024…”) sont bien plus susceptibles d’être citées et donc de générer de la visibilité, même dans un contexte de “zéro clic”.

| Caractéristique | Pourquoi ? | Exemple concret |

|---|---|---|

| Blocs sémantiques autonomes | Les LLMs extraient des passages, pas des pages. | “La Tesla Model Y offre 330 km d’autonomie et un coffre de 854 L.” (réponse complète en 1 phrase). |

| Comparaisons explicites | 60% des requêtes IA impliquent un choix. | “Contrairement au Mustang Mach-E, la Model Y a plus d’autonomie mais moins d’espace.” |

| Structuration modulaire | Facilite l’extraction par l’IA. | Listes à puces, FAQ, données structurées (Schema.org). |

| Sources vérifiables | Augmente les chances d’être cité. | “Selon l’EPA (2024), l’Ioniq 5 recharge à 350 kW.” |

L’émergence de l’ingénierie de la pertinence

Cette transformation profonde marque ce que certains experts commencent à appeler l’ère de l”ingénierie de la pertinence” (Relevance Engineering). Ce nouveau domaine dépasse largement le cadre traditionnel du SEO en intégrant des compétences en sémantique, en traitement du langage naturel et en analyse vectorielle.

La première rupture conceptuelle concerne la notion même de mot-clé. Dans un système qui fonctionne principalement par similarité sémantique calculée via des embeddings, l’idée de “densité de mots-clés” devient obsolète. Ce qui compte désormais, c’est la capacité d’un contenu à couvrir un spectre thématique large tout en maintenant une cohérence sémantique forte à différents niveaux de granularité.

La personnalisation atteint également des niveaux inédits. Grâce aux “user embeddings”, Google construit une représentation mathématique unique de chaque utilisateur, basée sur son historique de recherche, ses interactions avec les services Google (Gmail, YouTube, etc.), sa localisation et même le type d’appareil utilisé. Conséquence majeure : deux utilisateurs effectuant la même recherche peuvent obtenir des réponses radicalement différentes, adaptées à leur profil respectif. Cette variabilité rend les outils traditionnels de suivi de positionnement largement inopérants.

Le phénomène de “zéro clic” s’accentue avec le mode IA. Les données préliminaires suggèrent que dans de nombreux cas, les utilisateurs obtiennent une réponse si complète directement dans la page de résultats qu’ils n’ont plus besoin de visiter les sites sources. Pour les éditeurs web, cela signifie qu’il faut repenser complètement les indicateurs de performance, la visibilité dans les réponses générées et la qualité des citations devenant souvent plus importantes que le trafic direct.

S’adapter concrètement : stratégies et outils pour le nouveau paysage

Face à ces bouleversements, les professionnels du référencement doivent revoir leurs méthodes de travail et leur boîte à outils. Plusieurs approches concrètes émergent comme particulièrement prometteuses.

L’analyse des embeddings vectoriels devient une compétence clé. Il s’agit de comprendre comment vos contenus sont positionnés dans l’espace sémantique par rapport aux requêtes cibles et aux contenus concurrents. Des outils comme TensorFlow ou des librairies Python spécialisées permettent désormais de calculer et visualiser ces relations, même si les solutions clé en main restent rares dans les outils SEO traditionnels.

La simulation de raisonnement artificiel offre une autre piste intéressante. En utilisant des modèles de langage open-source ou des API comme celle de Gemini ou Chatgpt, il devient possible de tester comment un système IA pourrait traiter et utiliser vos contenus dans différentes chaînes de raisonnement. Cette approche permet d’identifier les passages les plus susceptibles d’être cités et ceux qui nécessitent des améliorations.

Le suivi des performances doit également évoluer vers ce qu’on pourrait appeler le “persona-based tracking”. Plutôt que de simplement mesurer les positions pour des requêtes génériques, il s’agit de construire des profils utilisateurs réalistes (avec historique de recherche, localisation, centres d’intérêt) et d’analyser comment les réponses varient en fonction de ces paramètres. Certaines plateformes innovantes comme Profound commencent à proposer ce type de fonctionnalités.

En parallèle, l’analyse des requêtes doit s’élargir considérablement. Des outils comme Profound (je n’ai pas encore testé, mais j’ai eu des bon retours) permettent de générer les sous-requêtes potentielles que Google pourrait créer à partir d’une recherche principale. Cette vision élargie du paysage sémantique est essentielle pour couvrir tous les angles pertinents.

Ce que révèlent les brevets : les secrets bien gardés de Google

L’analyse des brevets déposés par Google offre un éclairage fascinant sur les rouages cachés du mode IA. Plusieurs éléments méritent une attention particulière.

Les “user embeddings” représentent probablement l’innovation la plus disruptive. Ces profils vectoriels capturent l’essence du comportement d’un utilisateur à travers ses interactions avec l’écosystème Google. Un brevet récent décrit comment ces embeddings influencent chaque étape du processus, depuis l’interprétation de la requête jusqu’au format de la réponse finale. Cette personnalisation extrême explique pourquoi les résultats peuvent varier si fortement d’un utilisateur à l’autre.

Les mécanismes de citation constituent un autre sujet crucial. Contrairement à ce qu’on pourrait penser, les passages cités dans les réponses IA ne correspondent pas nécessairement aux pages les mieux classées pour la requête principale. Les brevets expliquent que la sélection se fait plutôt en fonction de l’adéquation avec une étape spécifique du raisonnement. Une page mal classée pour “meilleur SUV électrique” mais contenant une comparaison détaillée entre deux modèles précis a ainsi toutes les chances d’être citée.

Les données disponibles suggèrent que seulement 25% des pages en première position pour une requête donnée apparaissent effectivement dans les réponses générées (données ZipTie). Cet écart montre à quel point les anciennes métriques de performance deviennent inadéquates pour évaluer la visibilité réelle dans le nouveau système.

Conclusion

L’avènement du mode IA dans Google Search ne représente pas une simple évolution technique, c’est une refonte complète des fondements mêmes de la recherche en ligne. Les implications pour les professionnels du référencement sont profondes et multiples.

D’un point de vue stratégique, il devient clair que l’optimisation pour les moteurs de recherche traditionnels ne suffira plus à maintenir une visibilité significative. Les compétences requises évoluent vers ce qu’il convient d’appeler l”ingénierie de la pertinence”, une discipline intégrant la sémantique, l’analyse vectorielle et la compréhension des systèmes de raisonnement artificiel.

Les outils et méthodes traditionnels du SEO montrent déjà leurs limites face à ces nouvelles réalités. Le suivi des positions, l’analyse des mots-clés ou la mesure du trafic organique doivent être repensés pour rester pertinents. Dans le même temps, de nouvelles compétences techniques émergent comme essentielles, notamment dans le domaine de l’analyse sémantique et de la simulation des comportements IA.

Cette transformation ne concerne pas que les tactiques de référencement, elle interroge plus fondamentalement la manière dont nous concevons et structurons l’information en ligne. Comme le résume Mike King: “Nous ne préparons plus du contenu à être lu par des humains, mais à être digéré par des machines qui parlent aux humains.”

Face à ce bouleversement, pour moi une chose est certaine : ceux qui sauront adapter leurs pratiques et adopter ces nouveaux paradigmes dès aujourd’hui se construiront un avantage concurrentiel décisif pour les années à venir. Les règles du jeu ont changé, à nous d’écrire les nouvelles.